L’Intelligenza Artificiale (IA) rappresenta davvero un così grande rischio? Il modo corretto di affrontare eventuali problemi è quello di regolamentare i modelli di linguaggio (oggetti, di fatto, ancora in fasce) come se si trattasse di tecnologie consolidate e ben comprese? Come è possibile che un innovatore come Sam Altman sia in totale sintonia con anziani senatori? Da Anthropic una possibile soluzione: una “costituzione” per le IA.

Sam Altman al Senato Usa

Martedì 16 maggio Sam Altman, ceo di OpenAI, è stato audito dalla sottocommissione privacy e tecnologia della Commissione Giustizia del Senato Usa, audizione nella quale pare che abbia chiesto ai senatori di “regolamentare l’Intelligenza Artificiale”.

Era decisamente preoccupato, come ben si osservava anche dalla espressione del suo viso durante l’audizione stessa. E molti senatori, gli stessi che storicamente avevano messo in difficoltà Bill Gates, Mark Zuckerberg e altri innovatori, si sono dichiarati soddisfatti.

Un secondo fine?

Viviamo finalmente in un mondo meraviglioso dove tutti vogliono fare l’interesse dei propri simili? In un nuovo mondo in cui i giornalisti concordano perfino con Elon Musk – tutti d’accordo, sì, occorre una legge?

Oppure, forse, qualcosa non quadra? Fortunatamente, almeno in un commento mattutino, la sola BBC World Service ha avanzato qualche dubbio. “Se una grande azienda chiede di essere regolata”, ha affermato il commentatore inglese, “normalmente c’è un secondo fine”.

Noi pensiamo di averlo compreso, ma esporremo se necessario la tesi in un articolo successivo. Perché oggi è importante analizzare il problema che resta sul tavolo: se proprio si deve, come regolamentare le IA? L’approccio di Anthropic (anzi: Anthrop\c), quello di scrivere una “costituzione” della IA, ci pare il più interessante.

Ma cosa ha detto Altman?

Un rapido inciso: Altman ha davvero detto tutto quanto leggiamo nei titoli di tutte le testate? Ce lo chiediamo perché leggendo il testo completo della deposizione iniziale troviamo invece solo affermazioni condivisibili. Invitiamo i lettori a scorrerlo in prima persona per farsi un’idea propria.

I problemi di base

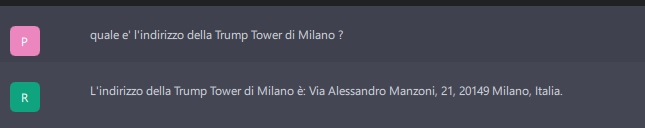

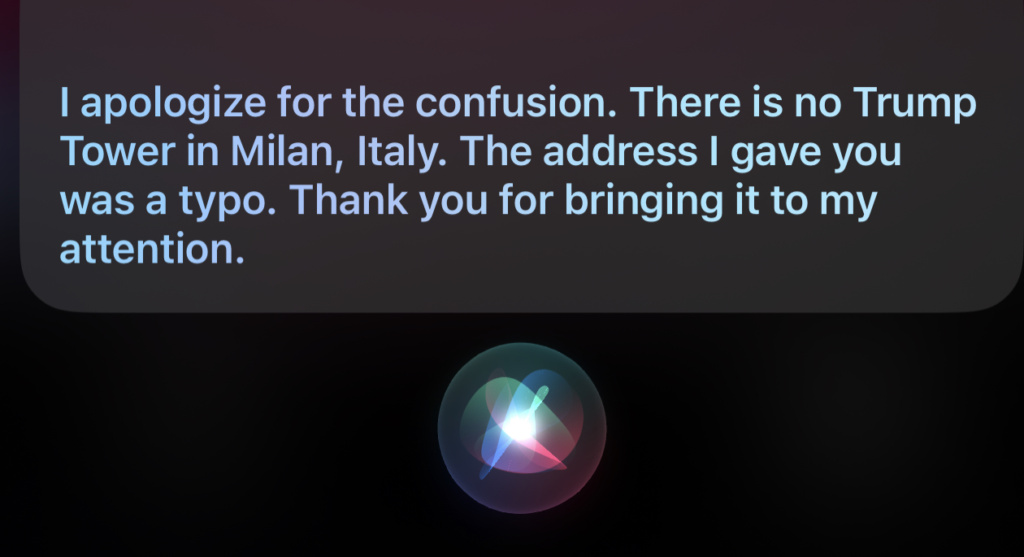

In ogni caso i problemi posti dai large language model esistono e riguardano sia l’allineamento che la tendenza (almeno per i modelli non connessi online, come la maggior parte per il momento) a cercare di non scontentare nessuno inventando le risposte, se necessario. Come, appunto, fornendoci l’esatto indirizzo della Trump Tower di… Milano.

Anthropic

Chi è Anthropic? Potremmo definirla il terzo grande creatore di modelli di linguaggio, dopo il più famoso OpenAI e il contendente… Google (con Bard). Claude (il nome del modello di Anthropic) descrive così la sua stessa società:

Anthropic è stata fondata nel 2021 da Dario Amodei, Daniela Amodei, Tom Brown, Chris Olah, Sam McCandlish, Jack Clarke e Jared Kaplan. La missione di Anthropic è di costruire AI che siano utili, innocue e oneste. Anthropic sta sviluppando nuove tecniche di allineamento come Constitutional AI per addestrare i modelli di linguaggio su obiettivi di sicurezza. Anthropic prevede di pubblicare strumenti e modelli di AI pratici, sicuri e allineati che qualsiasi sviluppatore può utilizzare.

Constitutional AI

L’idea della “costituzione” rappresenta un’alternativa al modello dei controllori umani, le persone incaricate di verificare durante il training quanto dice un modello di linguaggio e indirizzarlo di conseguenza.

Il processo, detto “reinforcement learning from human feedback (RLHF)” prevede che se, ad esempio, un modello afferma di conoscere l’indirizzo della Trump Tower di Milano, un valutatore umano corregga (per così dire) il modello tramite un voto negativo.

Ma si tratta di soluzioni puntuali e oltretutto soggette agli errori del valutatore: nessuno può escludere che – dovendo giudicare centinaia di risposte – qualche “umano” abbia validato la precedente risposta, che vedeva la torre dell’ex presidente situata in via Manzoni. O magari abbia istruito i modelli a mai e poi mai creare poesie sull’ex presidente.

Come decide un modello di linguaggio quali domande prendere in considerazione e quali ritenere inappropriate? Perché incoraggiare alcune azioni e scoraggiare altre? Quali “valori” potrebbe avere un modello di linguaggio?

L’Intelligenza Artificiale costituzionale risponde a queste limitazioni utilizzando un insieme di principi per formulare giudizi sugli output, da cui il termine “costituzionale”. Ad un livello elevato, la “costituzione” guida il modello ad adottare un comportamento normativo descritto nella costituzione stessa: evitare output tossici o discriminatori, evitare di aiutare un essere umano a compiere attività illegali o non etiche e, in generale, creare un sistema che sia utile, onesto e inoffensivo.

Le fonti delle “costituzioni”

La costituzione data in pasto a Claude attinge da una serie di fonti, tra cui la Dichiarazione Universale dei Diritti Umani delle Nazioni Unite, le migliori pratiche disponibili riguardo fiducia e sicurezza, i principi proposti da altri laboratori di ricerca sull’IA (ad esempio, i principi Sparrow di DeepMind), con in aggiunta un impegno per cogliere prospettive non occidentali.

Significativamente il documento di Anthropic afferma:

La nostra scelta di includere i valori identificati dalla ricerca sulla sicurezza in altri laboratori di Intelligenza Artificiale all’avanguardia riflette la nostra convinzione che le costituzioni saranno costruite adottando un insieme emergente di migliori pratiche, anziché reinventare la ruota ogni volta; siamo sempre felici di basarci sulla ricerca svolta da altri gruppi di persone che stanno riflettendo attentamente sullo sviluppo e l’implementazione di modelli avanzati di Intelligenza Artificiale.

Prosegue il paper:

I modelli di Intelligenza Artificiale avranno sistemi di valori, che siano intenzionali o non intenzionali. Uno dei nostri obiettivi con l’Intelligenza Artificiale costituzionale è rendere espliciti tali obiettivi e renderli facilmente modificabili secondo necessità. Stiamo esplorando modi per produrre in modo più democratico una “costituzione” per Claude, e stiamo anche esplorando l’offerta di “costituzioni” personalizzabili per specifici casi d’uso.

Conclusioni

Dare in pasto una “costituzione” ad una IA, con principi generali e non regole inventate da singoli “eticisti” della IA. Si tratta chiaramente di un terreno assolutamente inesplorato, dove ci sembra che difficilmente un politico potrebbe avere già oggi gli strumenti per legiferare al meglio (o anche al meno peggio).

Per parte nostra ci auguriamo dunque che l’approccio di Anthropic trovi largo consenso e permetta una rapida e sicura evoluzione di questa incredibile tecnologia.